机器之心的进化 / 理解 AI 驱动的软件 2.0 智能革命

机器之心的进化 / 理解 AI 驱动的软件 2.0 智能革命

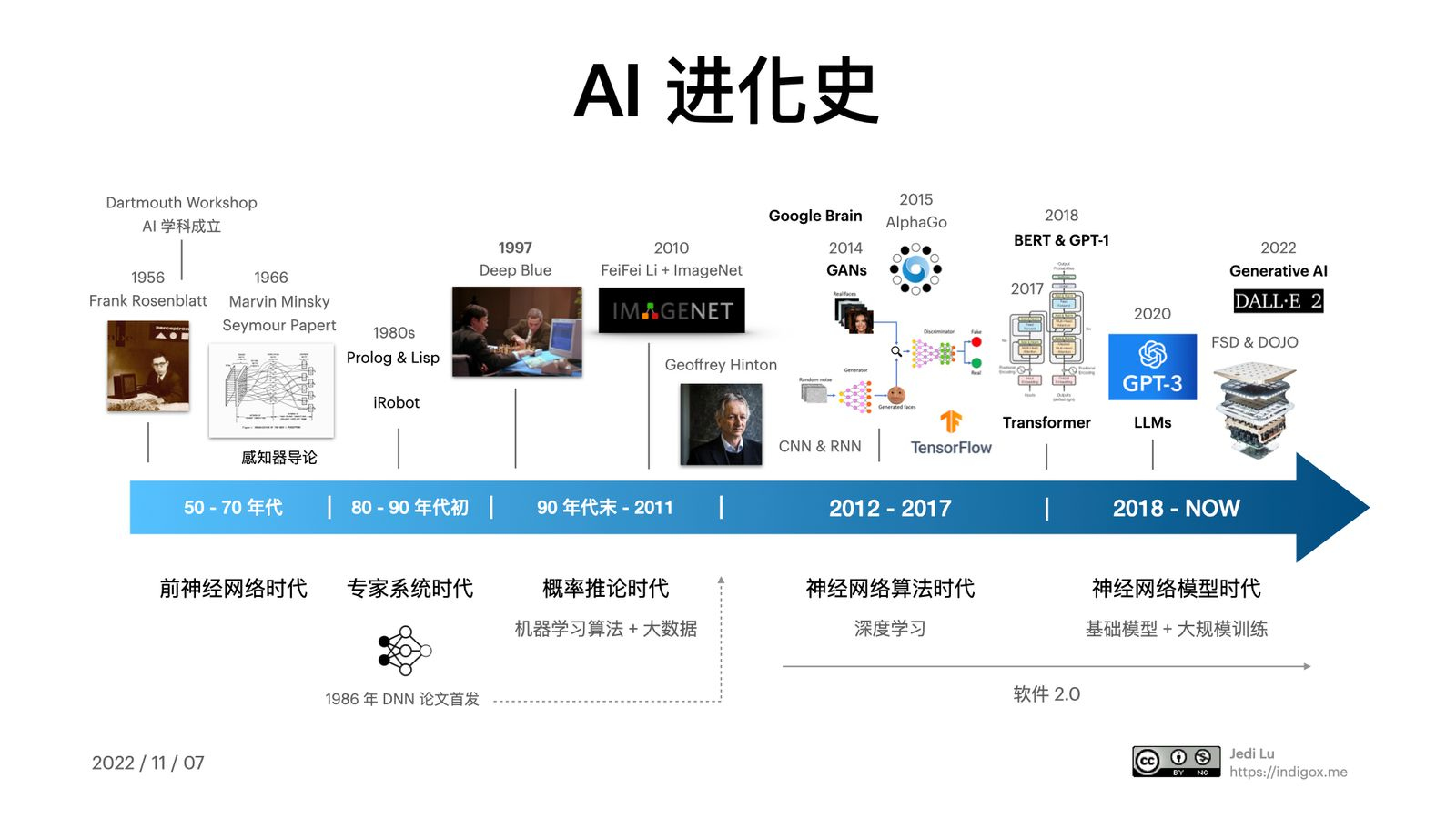

1、AI 进化史

1.1 前神经网络时代

神经网络 是以模仿人脑中的 神经元 的运作为 模型 的计算机系统。

1956 年,美国心理学家 Frank Rosenblatt 实现了一个早期的神经网络演示 - 感知器模型(Perceptron Model)

IBM 的 Georgetown 实验室在这些研究的基础上,实现了最早的机器语言翻译系统,可以在英语和俄语之间互译。

美国国防高级研究计划局(DARPA)在这个“黄金”时期,将大部分资金投入到 AI 领域,就在十年后他们还发明了 ARPANET(互联网的前身)。早期的 AI 先驱们试图教计算机做模仿人类的复杂心理任务,他们将其分成五个子领域:推理、知识表述、规划、自然语言处理(NLP)和 感知,这些听起来很笼统的术语一直沿用至今。

从专家系统到机器学习

1966 年,Marvin Minsky 和 Seymour Papert 在《感知器:计算几何学导论》一书中阐述了因为硬件的限制,只有几层的神经网络仅能执行最基本的计算,一下子浇灭了这条路线上研发的热情,AI 领域迎来了第一次泡沫破灭。

在上世纪八十年代,随着电脑性能的提升,新计算机语言 Prolog & Lisp 的流行,可以用复杂的程序结构,例如条件循环来实现逻辑,这时的人工智能就是 专家系统(Expert System),iRobot 公司绝对是那个时代明星;但短暂的繁荣之后,硬件存储空间的限制,还有专家系统无法解决具体的、难以计算的逻辑问题,人工智能再一次陷入窘境。

直到 IBM 深蓝在 1997 年战胜了国际象棋冠军卡斯帕罗夫后,新的基于概率推论(Probabilistic Reasoning)思路开始被广泛应用在 AI 领域,随后 IBM Watson 的项目使用这种方法在电视游戏节目《Jeopardy》中经常击败参赛的人类。

概率推论就是典型的机器学习(Machine Learning)。因为有了 ML,才有了大数据(Big Data)这个概念。

1.2 机器学习的跃迁

Deep Learning

深度学习(Deep Learning)是一种 机器学习 算法,它使用多层神经网络和反向传播(Backpropagation)技术来训练神经网络。该领域是几乎是由 Geoffrey Hinton 开创的,早在 1986 年,Hinton 与他的同事一起发表了关于深度神经网络(DNNs - Deep Neural Networks)的开创性论文,这篇文章引入了 反向传播 的概念,这是一种调整权重的算法,每当你改变权重时,神经网络就会比以前更快接近正确的输出,可以轻松的实现多层的神经网络,突破了 1966 年 Minsky 写的 感知器局限 的魔咒。

数据是新的石油

需要数据。而最重要的数据集之一,就是由 李飞飞 创建的 ImageNet。曾任斯坦福大学人工智能实验室主任,同时也是谷歌云 AI/ML 首席科学家的李飞飞

仅仅七年时间,ImageNet 让获胜算法对图像中的物体进行分类的准确率从 72% 提高到了 98%,超过了人类的平均能力。 ImageNet 成为深度学习革命的首选数据集,更确切地说,是由 Hinton 领导的 AlexNet 卷积神经网络(CNN - Convolution Neural Networks)的数据集。

经网络大爆发

2012 年以来深度神经网络算法开始大爆发,卷积神经网络(CNN)、递归神经网络(RNN - Recurrent Neural Network)和长短期记忆网络(LSTM - Long Short-Term Memory)等等,每一种都有不同的特性。例如,递归神经网络是较高层的神经元直接连接到较低层的神经元。

1.3 开启潘多拉的魔盒 ATTACH

GANs

生成对抗网络(GAN - Generative Adversarial Network) 是深度学习领域里面另一个重要的里程碑,诞生于 2014 年,它可以帮助神经网络用更少的数据进行学习,生成更多的合成图像,然后用来识别和创建更好的神经网络。GANs 的创造者 Ian Goodfellow 是在蒙特利尔的一个酒吧里想出这个主意的,它由两个神经网络玩着猫捉老鼠的游戏,一个创造出看起来像真实图像的假图像,而另一个则决定它们是否是真的。

大规模神经网络

大规模神经网络的竞赛从成立于 2011 年的 Google Brain开始,现在属于 Google Research。他们推动了 TensorFlow 语言的开发,提出了万能模型 Transformer 的技术方案并在其基础上开发了 BERT

在 2014 年被 Google 以 5.25 亿美元收购的 DeepMind 是这个时代的传奇。它专注游戏算法,其使命是 “解决智能问题”,然后用这种智能来 “解决其他一切问题”!DeepMind 的团队开发了一种新的算法 Deep Q-Network (DQN),它可以从经验中学习。2015 年 10 月 AlphaGo 项目首次在围棋中击败人类冠军李世石;之后的 AlphaGo Zero 用新的可以自我博弈的改进算法让人类在围棋领域再也无法翻盘。

OpenAI,它是一个由 Elon Musk, Sam Altman, Peter Thiel, 还有 Reid Hoffman 在 2015 年共同出资十亿美金创立的科研机构,其主要的竞争对手就是 DeepMind。OpenAI 的使命是 通用人工智能(AGI – Artificial General Intelligence),即一种高度自主且在大多数具有经济价值的工作上超越人类的系统。2020 年推出的 GPT-3 是目前最好的自然语言生成工具(NLP - Natural Language Processing)之一,通过它的 API 可以实现自然语言同步翻译、对话、撰写文案,甚至是代码(Codex),以及现在最流行的生成图像(DALL·E)。

Gartner AI HypeCycle ATTACH

Gartner 的技术炒作周期(HypeCycle)很值得一看

神经网络,这个在上世纪 60 年代碰到的挫折,然后在 2012 年之后却迎来了新生。反向传播 花了这么长时间才被开发出来的原因之一就是该功能需要计算机进行 乘法矩阵运算。

2、软件 2.0 的崛起

Software 2.0 概念的最早提出人是 Andrej Karpathy,这位从小随家庭从捷克移民来加拿大的天才少年在多伦多大学师从 Geoffrey Hinton,然后在斯坦福李飞飞团队获得博士学位,主要研究 NLP 和计算机视觉,同时作为创始团队成员加入了 OpenAI,深度学习的关键人物和历史节点都被他点亮。在 2017 年被 Elon Musk 挖墙脚到了 Tesla 负责自动驾驶研发,然后就有了重构的 FSD(Full Self-Driving)。

Andrej Karpathy 的定义 - “软件 2.0 使用更抽象、对人类不友好的语言生成,比如神经网络的权重。没人参与编写这些代码,一个典型的神经网络可能有数百万个权重,用权重直接编码比较困难”。

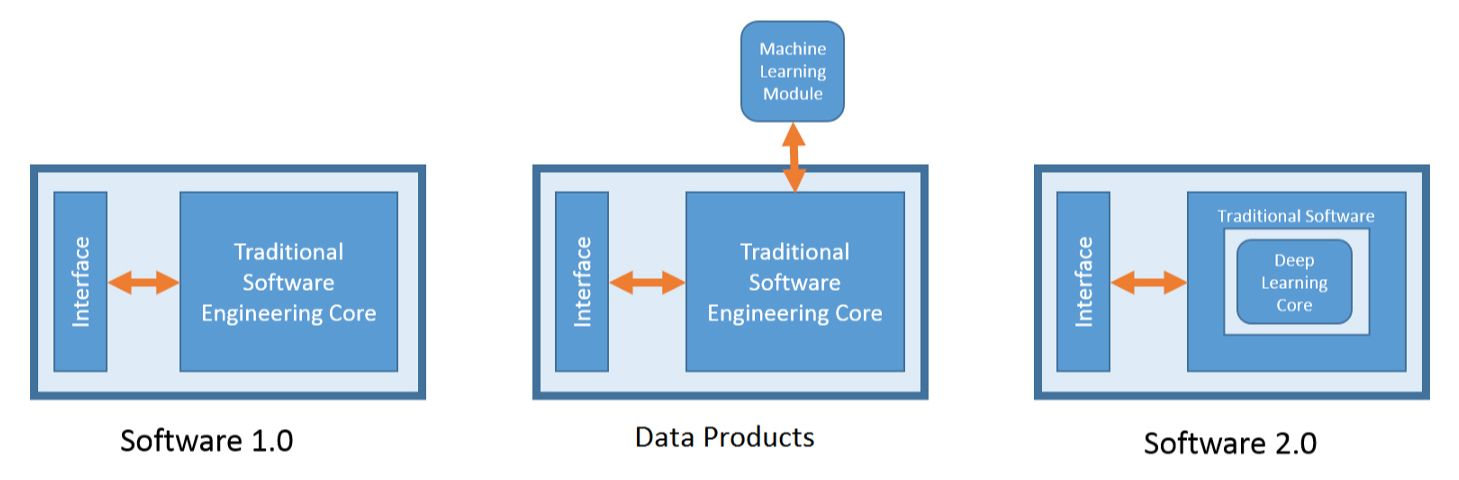

2.1 范式转移

神经网络不仅仅是另一个分类器,它代表着我们开发软件的 范式开始转移,它是 软件 2.0。 软件 1.0 人们编写代码,编译后生成可以执行的二进制文件;但在软件 2.0 中人们提供数据和神经网络框架,通过训练将数据编译成二进制的神经网络。

2.2 软件的演化 ATTACH

软件从 1.0 发展到软件 2.0,经过了一个叫做“数据产品”的中间态。 Ahmad Mustapha 的一篇文章《The Rise of Software 2.0》很好地呈现了这个过渡。

这个中间态也叫 大数据 和 算法推荐。 数据产品有几个重要特点:1、它们都不是软件的主要功能,通常是为了增加体验,达成更好的用户活跃以及销售目标;2、能够随着数据的增加而进化;3、大部分都是基于传统 ML 实现的,最重要的一点 数据产品是可解释的。

2.3 软件 2.0 的优势

为什么我们应该倾向于将复杂的程序移植到软件 2.0 中?Andrej Karpathy 在《Software 2.0》中给出了一个简单的答案:它们在实践中表现得更好!

容易被写入芯片

由于神经网络的指令集相对较小,主要是矩阵乘法(Matrix Multiplication)和阈值判断(Thresholding at Zero),因此把它们写入芯片要容易得多,例如使用定制的 ASIC、神经形态芯片等等(Alan Turing 在设计 ACE 时就这样考虑了)。

- 非常敏捷

- 模块可以融合成一个最佳的整体

- 它做得比你好

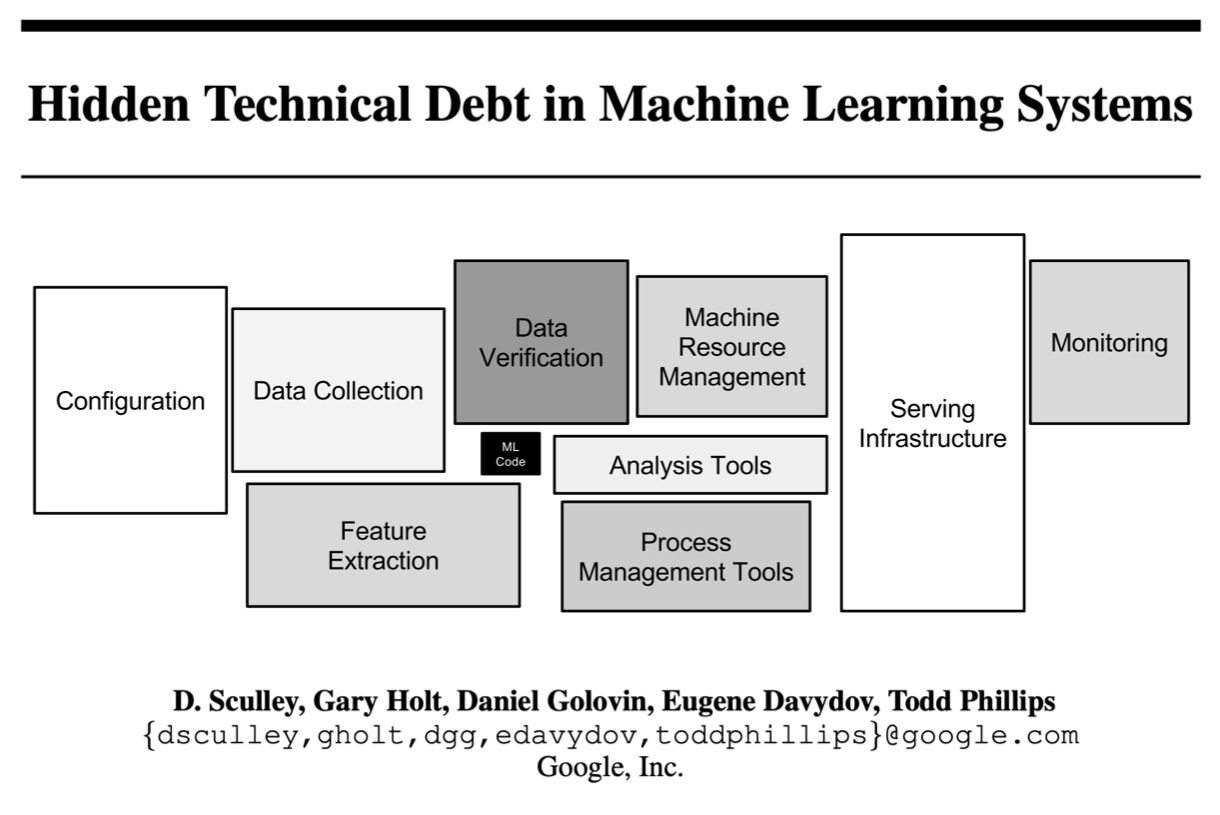

2.4 Bug 2.0

软件 2.0 带来了两个新问题:不可解释 和 数据污染。

在 2.0 的堆栈中,数据决定了神经网络的连接,所以不正确的数据集和标签,都会 混淆神经网络。

3、面向智能的架构

今天你需要 大量的数据 和 分布式系统 才能大规模的部署人工智能。经济学大师 Andrew McAfee 和 Erik Brynjolfsson 在他们的著作《Machine, Platform, Crowd: Harnessing Our Digital Future》中讽刺的调侃:“我们的机器智能时代仍然是人力驱动的”。

3.1 Infrastructure 3.0 ATTACH

Infrastructure 1.0 - C/S(客户端/服务器时代) 商业互联网在上世纪 90 年代末期成熟起来,这要归功于 x86 指令集(Intel)、标准化操作系统(Microsoft)、关系数据库(Oracle)、以太网(Cisco)和网络数据存储(EMC)。Amazon,eBay,Yahoo,甚至最早的 Google 和 Facebook 都建立在这个我们称之为 Infrastructure 1.0 的基础上。

Infrastructure 2.0 - Cloud(云时代) Amazon AWS、Google Cloud 还有 Microsoft Azure 定义了一种新的基础设施类型,这种基础设施是无需物理部署可持续运行的、可扩展的、可编程的,它们有些是开源,例如 Linux、MySQL、Docker、Kubernetes、Hadoop、 Spark 等等,但大多数都是要钱的,例如边缘计算服务 Cloudflare、数据库服务 MangoDB、消息服务 Twilio、支付服务 Stripe,所有这些加在一起定义了 云计算时代。推荐阅读我在 2021 年 9 月的这篇《软件行业的云端重构》。

Infrastructure 2.0 关注的问题是 - “我们如何连接世界?” 今天的技术重新定义了这个问题 - “我们如何理解这个世界?”

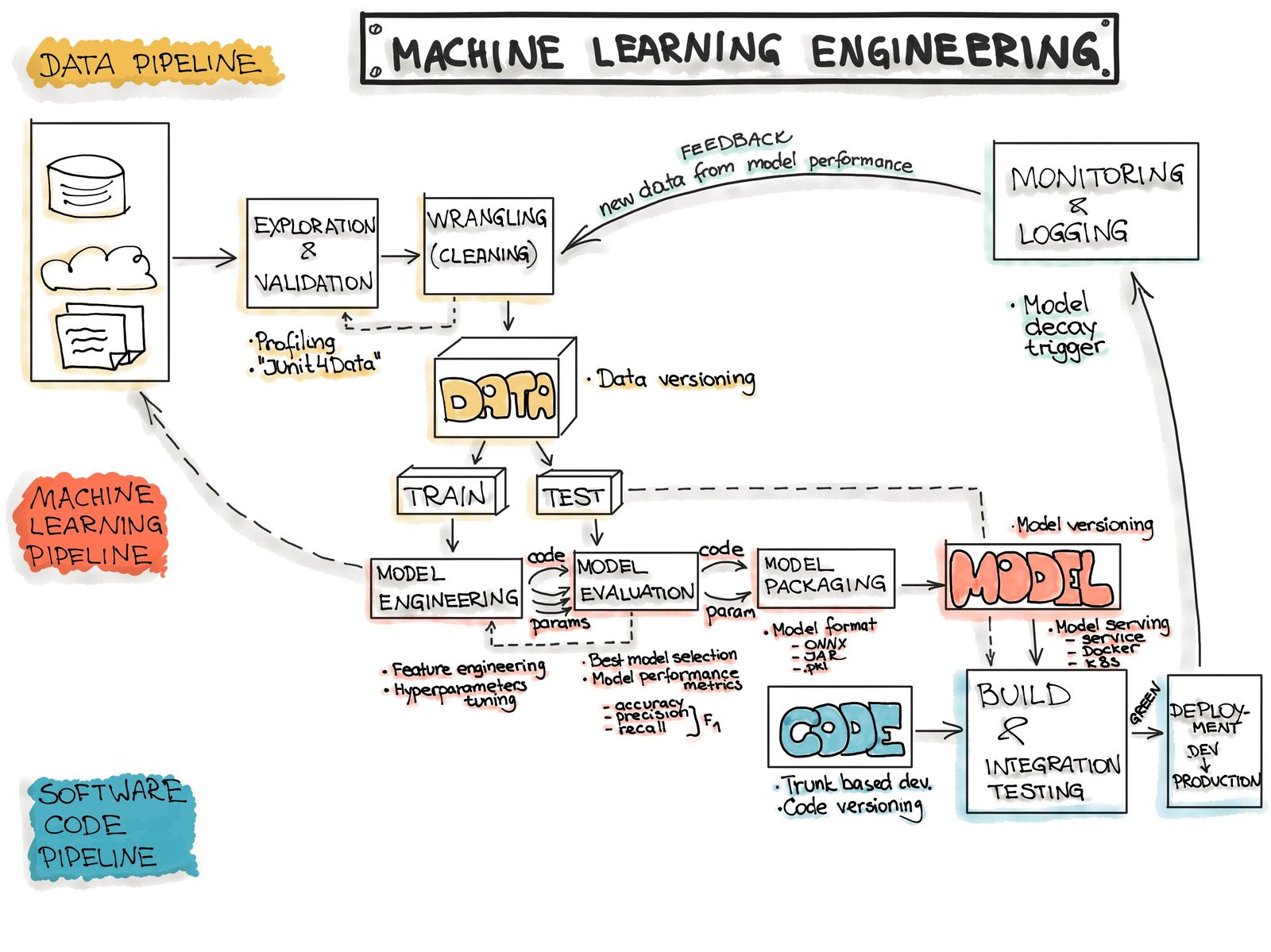

3.2 如何组装智能 ATTACH

参照智能架构领域的投资专家 Amplify Partners 的分类,简单做个技术栈说明。

- 为机器学习优化的高性能芯片,它们内置多计算核心和高带宽内存(HBM),可以高度并行化,快速执行矩阵乘法和浮点数学神经网络计算,例如 Nvidia 的 H100 Tensor Core GPU 还有 Google 的 TPU;

- 能够完全发挥硬件效率的系统软件,可以将计算编译到晶体管级别。Nvidia 在 2006 年就推出的 CUDA 到现在也都保持着领先地位,CUDA 是一个软件层,可以直接访问 GPU 的虚拟指令集,执行内核级别的并行计算;

- 用于训练和推理的分布式计算框架(Distributed Computing Frameworks),可以有效地跨多个节点,扩展模型的训练操作;

- 数据和元数据管理系统,为创建、管理、训练和预测数据而设计,提供了一个可靠、统一和可重复使用的管理通道。

- 极低延迟的服务基础设施,使机器能够快速执行基于实时数据和上下文相关的智能操作;

- 机器学习持续集成平台(MLOps),模型解释器,质保和可视化测试工具,可以大规模的监测,调试,优化模型和应用;

- 封装了整个机器学习工作流的终端平台(End to End ML Platform),抽象出全流程的复杂性,易于使用。几乎所有的拥有大用户数据量的 2.0 架构公司,都有自己内部的 3.0 架构集成系统,Uber 的 Michelangelo 平台就用来训练出行和订餐数据; Google 的 TFX 则是面向公众提供的终端 ML 平台,还有很多初创公司在这个领域,例如 Determined AI。

3.3 智能架构的先锋

2010 年。在 Palo Alto 的一家日餐晚宴上,斯坦福大学教授 Andrew Ng 在那里会见了 Google 的 CEO Larry Page 和当时担任 Google X 负责人的天才计算机科学家 Sebastian Thrun。就在两年前,Andrew 写过一篇关于将 GPU 应用于深度学习模型有效性分析论文。

几乎在同一时期,Nvidia 的 CEO Jensen Huang 也意识到 GPU 对于深度学习的重要性,他是这样形容的:”深度学习就像大脑,虽然它的有效性是不合理的,但你可以教它做任何事情。这里有一个巨大的障碍,它需要大量的计算,而我们就是做 GPU 的,这是一个可用于深度学习近乎理想的计算工具”。

以上故事的细节来自 Forbes 在 2016 年的一篇深度报道《The New Intel: How Nvidia Went From Powering Video Games To Revolutionizing Artificial Intelligence》。自那时起,Nvidia 和 Google 就走上了深度学习的智能架构之路,一个从终端的 GPU 出发,另一个从云端的 TPU 开始。

Nvidia 在软件堆栈上的能力这些硬件公司无人能及,因为它有从内核到算法全面控制的 CUDA,还能让数千个芯片协同工作。这种整体控制力,让 Nvidia 可以发展云端算力服务,自动驾驶硬件以及嵌入式智能机器人硬件,以及更加上层的 AI 智能应用和 Omniverse 数字模拟世界。

像 GANs 这样充满灵感的想法也是来自于 Google (Ian Goodfellow 同学当时任职于 Google Brain)。在 2015 年前后 Google 先后推出了 TensorFlow 还有 TPU(Tensor Processing Unit - 张量芯片),同年还收购了 DeepMind 来扩张研究实力。

4、一统江湖的模型

这种多用途的新型锤子是一种神经网络,我们称之为 Transformer(转换器模型 - 不是动画片里的变形金刚)

4.1 Transformer 的诞生

2017 年 Google Brain 和多伦多大学的研究人员一同发表了一篇名为《Attention Is All You Need》的论文,里面提到了一个自然语言处理(NLP)的模型 Transformer,这应该是继 GANs 之后深度学习领域最重大的发明。2018 年 Google 在 Transformer 的基础上实现并开源了第一款自然语言处理模型 BERT;虽然研究成果来自 Google,但很快被 OpenAI 采用,创建了 GPT-1 和最近的火爆的 GPT-3。其他公司还有开源项目团队紧随其后,实现了自己的 Transformer 模型,例如 Cohere,AI21,Eleuther(致力于让 AI 保持开源的项目);也有用在其它领域的创新,例如生成图像的 Dall-E 2、MidJourney、Stable Diffusion、Disco Diffusion, Imagen 和其它许多。

序列传导模型(Seq2Seq)是用于 NLP 领域的一种深度学习模型,在机器翻译、文本摘要和图像字幕等方面取得了很大的成功,2016 年之后 Google 在搜索提示、机器翻译等项目上都有使用。序列传导模型是在 输入端 一个接一个的接收并 编码 项目(可以是单词、字母、图像特征或任何计算机可以读取的数据),并在同步在 输出端一个接一个 解码 输出项目的模型。

Transformer 也是一款用于 NLP 的序列传导模型,论文简洁清晰的阐述了这个新的网络结构,它只基于 注意力机制(Attention),完全不需要递归(RNN)和卷积(CNN)。在两个机器翻译的实验表明,这个模型在质量上更胜一筹,同时也更容易并行化,需要的训练时间也大大减少。

推荐阅读 Giuliano Giacaglia 的这篇《How Transformers Work》。

4.2 Foundation Models

斯坦福大学 CRFM & HAI 的研究人员在 2021 年 8 月的一篇名为《On the Opportunities and Risks of Foundation Models》的论文中将 Transformer 称为 Foundation Models(基础模型)

从 NLP 到 Generative AI

来自 Google Brain 的计算机科学家 Maithra Raghu 分析了视觉转换器(Vision Transformer),以确定它是如何“看到”图像的。与 CNN 不同,Transformer 可以从一开始就捕捉到整个图像,而 CNN 首先关注小的部分来寻找像边缘或颜色这样的细节。

计算机科学家 Atlas Wang 这样表述, “我认为 Transformer 之所以如此受欢迎,是因为它暗示了一种变得通用的潜力,可能是朝着实现某种神经网络结构大融合方向的重要一步,这是一种通用的计算机视觉方法,或许也适用于其它的机器智能任务”。

更多基于Transformer 模型的 Generative AI 案例,推荐好友 Rokey 的这篇《AI 时代的巫师与咒语》,这应该是中文互联网上写得最详细清晰的一篇。

涌现和同质化

Foundation Models 的意义可以用两个词来概括:涌现和同质化。涌现 是未知和不可预测的,它是创新和科学发现的源头。同质化 表示在广泛的应用中,构建机器学习的方法论得到了整合;它让你可以用统一的方法完成不同的工作,但也创造了单点故障。

AI 的进化史一个不断涌现和同质化的过程。随着机器学习的引入,可以从实例中学习(算法概率推论);随着深度学习的引入,用于预测的高级特征出现;随着基础模型(Foundation Models)的出现,甚至出现了更高级的功能,在语境中学习。同时,机器学习将算法同质化(例如 RNN),深度学习将模型架构同质化(例如 CNN),而基础模型将模型本身同质化(如 GPT-3)。

大规模语言模型

自然语言 = 编程方式 = 通用界面。

因此,大规模语言模型(LLMs - Large Scale Language Models)成了科技巨头和新创业公司必争之地。在这个军备竞赛之中,财大气粗就是优势 ,它们可以花费数亿美元采购 GPU 来培训 LLMs,例如 OpenAI 的 GPT-3 有 1750 亿个参数,DeepMind 的 Gopher 有 2800 亿个参数,Google 自己的 GLaM 和 LaMDA 分别有 1.2 万亿个参数和 1370 亿个参数,Microsoft 与 Nvidia 合作的 Megatron-Turing NLG 有 5300 亿个参数。

AI 有个特征它是 涌现 的,大多数情况挑战是科学问题,而不是工程问题。

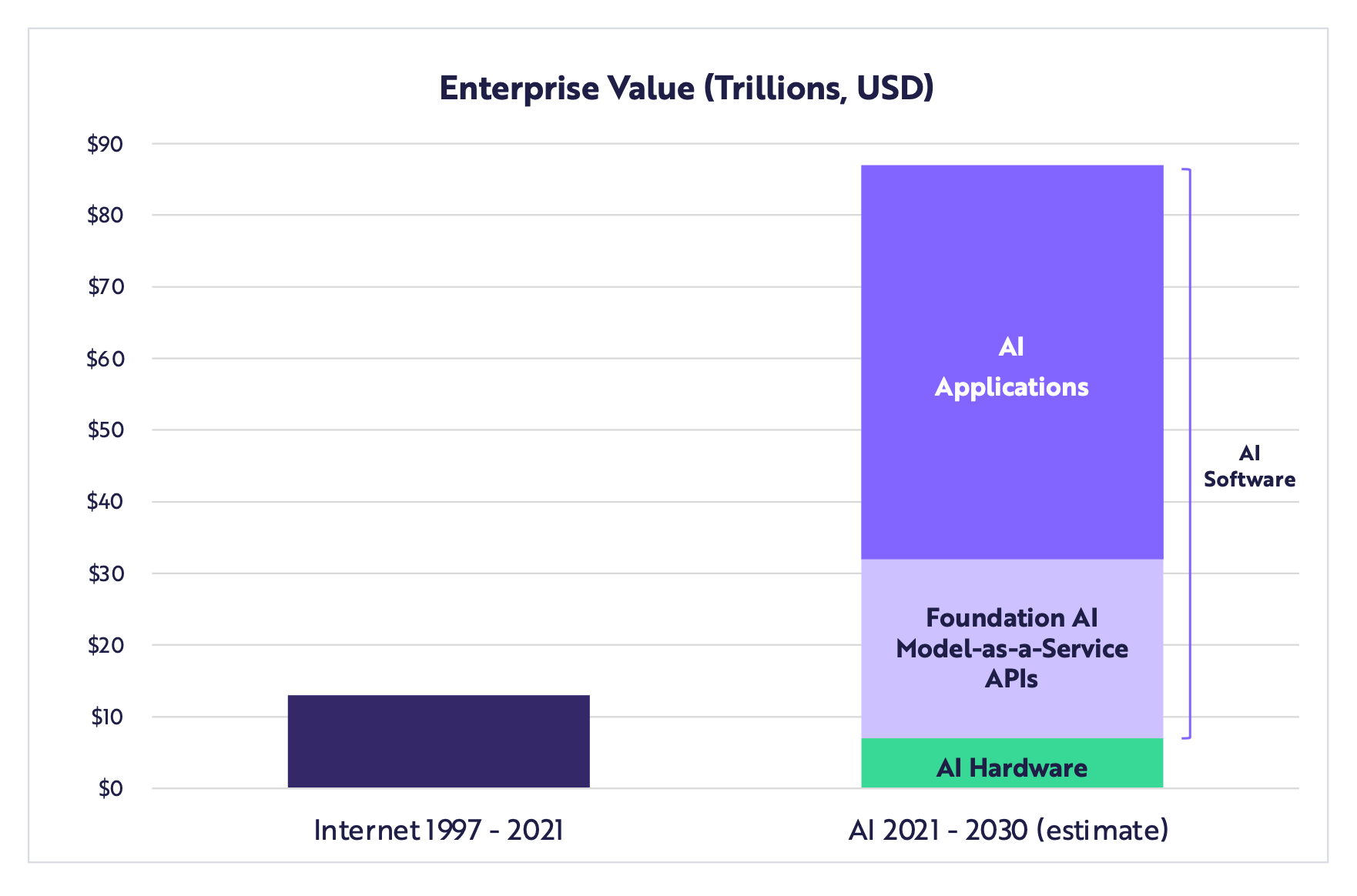

4.3 AI 江湖的新机会

机器能理解文档或者直接生成文档,将是自 2010 年前后的移动互联网革命和云计算以来,最具颠覆性的转变之一。参考移动时代的格局,我们最终也会有三种类型的公司,这里参照了 Elad 的这篇文章《AI Revolution - Transformers and Large Language Models》:

1、平台和基础设施(Platforms & Infrastructure)

移动平台的终点是 iPhone 和 Android,这之后都没有任何机会了。但在基础模型领域 OpenAI、Google、Cohere、AI21、Stability.ai 还有那些构建 LLMs 的公司的竞争才刚刚开始。

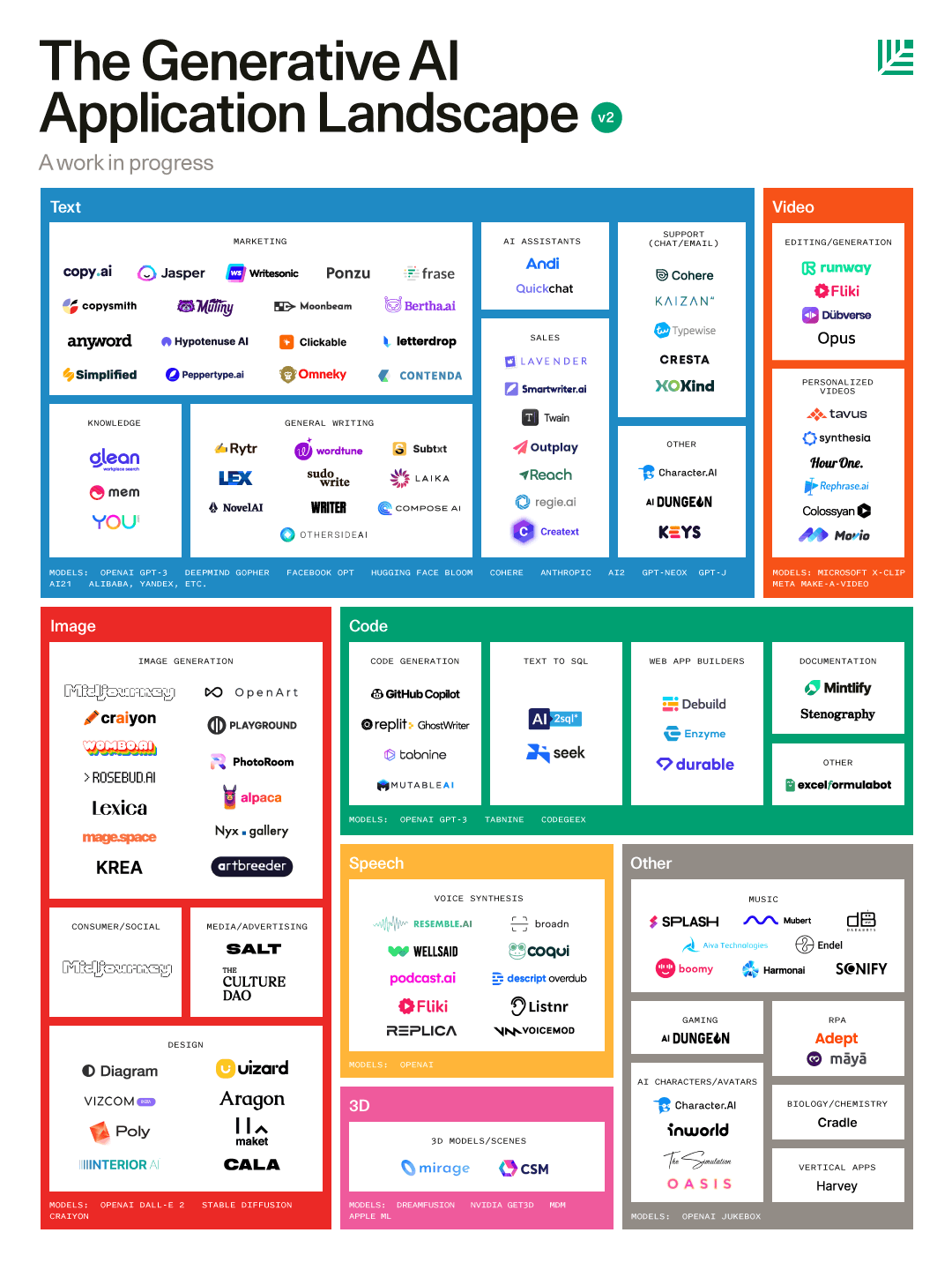

2、平台上的独立应用(Stand alone applications built on top of the platforms) ATTACH

红衫资本美国( SequoiaCap)最近一篇很火的文章《Generative AI: A Creative New World》详细分析了这个市场和应用

3、现有产品智能化(Tech-enabled incumbents)

在移动互联网的革命中,大部分有价值的移动业务依旧被上个时代的巨头所占据。例如,当许多初创公司试图建立“Mobile CRM”应用时,赢家是增加了移动支持的 CRM 公司,Salesforce 没有被移动应用取代。

5、现实世界的 AI

现实世界的 AI(Real World AI),按照 Elon Musk 的定义 就是 “模仿人类来感知和理解周围的世界的 AI”,它们是可以与人类世界共处的 智能机器。

5.1 自动驾驶新前沿

技术路线的选择

目前的自动驾驶主要两大流派:纯视觉的系统 和基于 激光雷达的系统。Google 的 Waymo 是激光雷达方案的先驱,还有刚破产的 Argo AI 也是,优势很明显,激光雷达可以精准的识别三维世界,不需要太复杂的神经网络训练就能轻松上路,但大功率激光雷达的成本是个大问题;采用纯视觉方案的只有 Tesla 和 Comma 这样的另类公司,它们完全靠摄像头和软件,无需任何辅助感知硬件。

激光雷达还有另一个问题,它眼中的世界没有色彩也没有纹理,必须配合摄像头才能描绘真实世界的样子。但两种数据混合起来会让算法极其复杂

Waymo 和 Tesla 是自动驾驶领域的领跑者,Gartner 的副总裁 Mike Ramsey 这样评价:“如果目标是为大众提供自动驾驶辅助,那么 Tesla 已经很接近了;如果目标让车辆能够安全的自动行驶,那么 Waymo 正在取得胜利”。Waymo 是 Level 4,可以在有限的地理条件下自动驾驶,不需要司机监督,但驱动它的技术还没有准备好让其在测试领域之外的大众市场上使用,而且造价昂贵。从 2015 年开始,Tesla 花了六年多的时间赶上了 Waymo 现在的测试数据,同时用于自动驾驶的硬件越来越少,成本越来越低。Tesla 的战略很有意思:“自动驾驶要适应任何道路,让车像人一样思考”,如果成功的话,它的可扩展性会大得多。

让车看见和思考

Tesla 在 AI 上的押注是从 2017 年 Andrej Karpathy 的加入开始的,一个灵魂人物确实能改变一个行业。Andrej 领导的 AI 团队完全重构了原有的自动驾驶技术,采用最新的神经网络模型 Transformer 训练了完全基于视觉的自动导航系统 FSD Beta 10,在 2021 年的 AI Day 上,Tesla AI 团队也毫无保留了分享了这些最新的研发成果,目的是为了招募更多人才加入。

FSD 的自动驾驶步骤大概如下:

- 视觉影像收集:通过车载的 6 个 1280x960 解析度的摄像头,采集 12bit 色深的视频,识别出环境中的各种物体和 Triggers(道路情况)

- 向量空间生成:人类看到的世界是大脑根据感知数据实时构建还原的三维世界,Tesla 用同样的机制把车周围世界的全部信息都投射到四维向量空间中,再做成动态的 BEV 鸟瞰图,让车在立体的空间中行使和预测,从而可以精准控制。在 2021 年之前采用的是基于 Transformer 模型的 HydraNets,现在已经升级到最新的 Occupancy Networks,它可以更加精准的识别物体在 3D 空间中的占用情况

- 神经网络路线规划:采用蒙特卡洛算法(mcts)在神经网络的引导下计算,快速完成自己路径的搜索规划,而且算法还能给所有移动的目标都做计划,并且可以及时改变计划。看别人的反应作出自己的决策,这不就是人类思维么?

5.2 不是机器人,是智能代理

驱动 Tesla 汽车的 FSD 技术同样会用来驱动 Tesla Optimus 机器人,他们有相同的心脏(FSD Computer)和相同的大脑(Tesla Dojo)。

虚拟世界中的模拟真实 ATTACH

为机器人感知世界建立新的 基础模型 将需要跨越不同环境大量数据集 学界对使用这些数据在虚拟环境中训练的 智能代理 有个专门的分类 EAI(Embodied artificial intelligence)。 李飞飞再次走在了前列,她的团队发布了一个标准化的模拟数据集 BEHAVIOR,包含 100 个类人常见动作,例如捡玩具、擦桌子、清洁地板等等

ARK Invest 在他们的 Big Ideas 2022 报告中提到,根据莱特定律,AI 相对计算单元(RCU - AI Relative Compute Unit)的生产成本可以每年下降 39%,软件的改进则可以在未来八年内贡献额外 37% 的成本下降。换句话说,到 2030 年,硬件和软件的融合可以让人工智能训练的成本以每年 60% 的速度下降。

6、AI 进化的未来

科幻小说家 Arthur Clarke 这样说过:”任何先进的技术都与魔法无异”!

6.1 透视神经网络

大脑中的 Transformer

来自 University College London 的两位神经科学家 Tim Behrens 和 James Whittington 帮助证明了我们大脑中的一些结构在数学上的功能与 Transformer 模型的机制类似,具体可以看这篇《How Transformers Seem to Mimic Parts of the Brain》,研究显示了 Transformer 模型精确地复制在他们 大脑海马体 中观察到的那些工作模式。

6.2 千脑理论

Jeff Hawkins 是 Palm Computing 和 Handspring 的创始人,也是 PalmPilot 和 Treo 的发明人之一。创办企业之后,他转向了神经科学的工作,创立了红木理论神经科学中心(Redwood Center),从此专注人类大脑工作原理的研究,Hawkins 在 2003 年当选为美国国家工程院(NAE)院士。《A Thousand Brains》这本书详细的解释了他最重要的研究成,湛庐文化在今年九月推出了中文版《千脑智能》。

大脑新皮层(Neocortex)是智力的器官。几乎所有我们认为是智力的行为,如视觉、语言、音乐、数学、科学和工程,都是由新皮层创造的。Hawkins 对它工作机理采取了一种新的解释框架,称为 “Thousand Brains Theory”,即你的大脑被组织成成千上万个独立的计算单元,称为皮质柱(Cortical Columns)。这些柱子都以同样的方式处理来自外部世界的信息,并且每个柱子都建立了一个完整的世界模型。但由于每根柱子与身体的其他部分有不同的联系,所以每根柱子都有一个独特的参考框架。你的大脑通过进行投票来整理出所有这些模型。因此,大脑的基本工作不是建立一个单一的思想,而是管理它每时每刻都有的成千上万个单独的思想。

我们可以把运行 Transformer 训练的神经网络的电脑想象成一个及其简陋的人工皮质柱

千脑理论 本质上是一种感觉-运动理论(Sensory-Motor Theory),它解释了我们如何通过看到、移动和感知三维空间来学习和识别物体。在该理论中,每个 皮质柱 都有完整物体的模型,因此知道在物体的每个位置应该感应到什么。

要像大脑一样学习

自我监督:新皮层的计算单位是皮质柱,每个柱子都是一个完整的感觉-运动系统,它获得输入,并能产生行为。

持续学习:大脑持续学习的最重要组成部分是神经元。当一个神经元学习一个新的模式时,它在一个树突分支上形成新的突触。新的突触并不影响其他分支上先前学到的突触。

多模型机制的:新皮层由数以万计的皮质柱组成,每根柱子都会学习物体的模型,使多模型设计发挥作用的关键是投票。

有自己的参考框架:大脑中的知识被储存在参考框架中。参考框架也被用来进行预测、制定计划和进行运动,当大脑每次激活参考框架中的一个位置并检索相关的知识时,就会发生思考。

为什么需要通用人工智能(AGI)

AI 将从我们今天看到的专用方案过渡到更多的通用方案,这些将在未来占据主导地位,Hawkins 认为主要有两个原因: 第一个就和通用电脑战胜专用电脑的原因一样。通用电脑有更好的成效比,这导致了技术的更快进步。 Al 将通用化的第二个原因是,机器智能的一些最重要的未来应用将需要通用方案的灵活性,例如 Elon Musk 就希望可以自我学习的机器人来帮忙探索火星。

6.3 人工智能何时通用?

回顾 机器之心 六十多年的进化,我们似乎找到了方法,就是模仿人类的大脑。机器学习要完成这块拼图,需要有 数据、算力 还有 模型的改进。

数据 应该是拼图中最容易实现的。 算力 可以分解为两个部分:神经网络的参数(神经元的数量和连接)规模以及单位计算的成本。

当 AI 变得比人类更聪明、我们称这一刻为 奇点。一些人预测,奇点最快将于 2045 年到来。

从工具进化到数字生命

到那时,我们对机器意识的概念将有一些重大的转变,我们将面对真正的数字生命形式(DILIs - Digital Lifeforms)。 关于 DILIs 这个有趣的话题在《Life 3.0》和《Superintelligence: Paths, Dangers, Strat》

Elad Gil 在他的最新文章《AI Revolution》提到 OpenAI、Google 和各种创业公司的核心 AI 研究人员都认为,真正的 AGI 还需要 5 到 20 年的时间才能实现,这也有可能会像自动驾驶一样永远都在五年后实现。